NVIDIA Jarvis - 3Dチャットボット

こんにちは、うしじです。

5/14のGTC2020で、NVIDIAが対話型AIのフレームワークであるJarvisを発表しました。

GTC 2020 Keynote Part 5: NVIDIA Jarvis for Conversational AI

まずは、GTC 2020の下記動画を見てみてください。

CGのキャラクターが人のように話して面白くないですか!?

Jarvisを使えば、このような3Dチャットボットを作成することができるようです。

(3Dモデルの開発とか、どこまで追加対応が必要かはよくわかりませんが。)

また、今はまだEarly Accessの募集中の段階で、自由に使うということはできなさそうです。

Pre-Trained Model

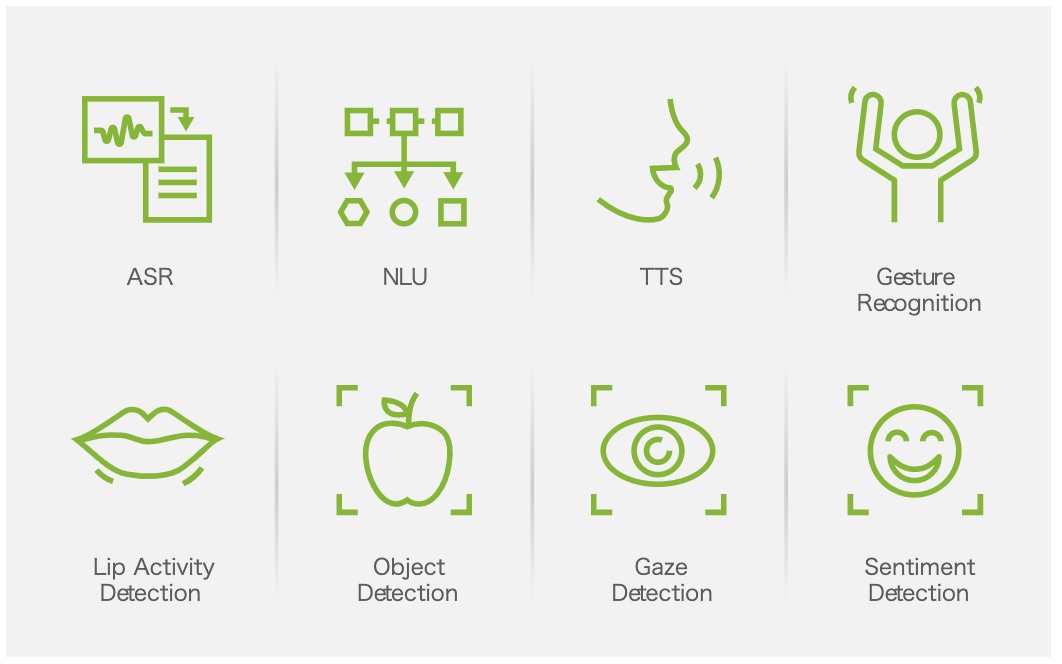

Jarvisには、下記のPre-Trained Modelを利用することができ、これらのモデルを必要に応じて追加で学習させることにより、自身の用途に合わせた開発ができるようです。

(参照:https://developer.nvidia.com/nvidia-jarvis)

(参照:https://developer.nvidia.com/nvidia-jarvis)

- ASR (Automatic Speech Recognition)

- NLU (Natural Language Understanding)

- TTS (Text to Speech)

- Gesture Recognition

- Lip Activity Detection

- Object Detection

- Gaze Detection

- Sentiment Detection

(音声に合わせて3D CGを動かす、Audio2Faceは別なんですかね?)

ここが凄そう

GTC 2020の動画を見ると、Audio2Faceのところを売りにしているように思えますが、個人的には、Gesture RecognitionやGaze Detection、Sentiment Detection等のカメラから得られる情報も組み合わせて会話AIを構築している点がすごいと思っています。

NLUやTTS、STT(Speech to Text)、Transformer等を利用した会話AIは、かなり発展してきていると思いますが、ジェスチャー等のNonーverbalなコミュニケーションや、表情や口調に現れる感情も理解して対話可能なAIはまだ出てきていないと思っています。

また、そういった対話を成り立たせる際に、Misty等の何かしらのキャラクターも重要になってくると思っています。会話する対象がいて、目を合わせて会話することで、より自然な会話を実現できると思っています。

早く日本語に対応されて、自由に使えるようになって欲しいですね。